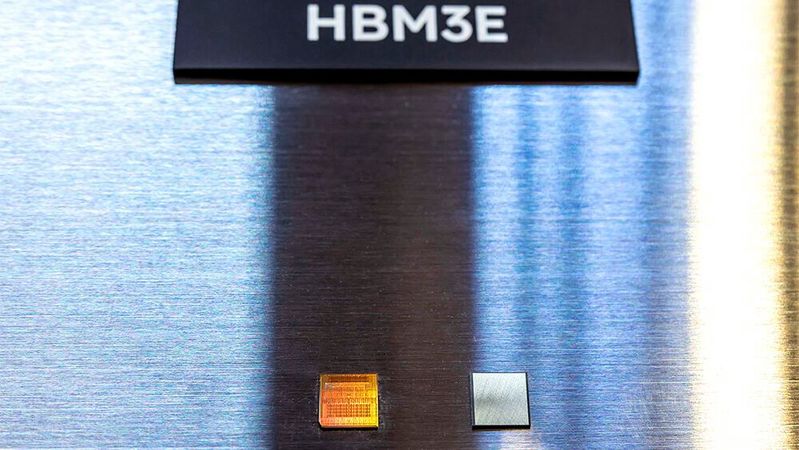

Gefragt in Hochleistungsanwendungen Ausverkauft: Die geplante HBM-Jahresproduktionsmenge von SK hynix

Anbieter zum Thema

Eigenen Worten zufolge hat SK hynix bereits die für dieses Jahr geplante Produktionsmenge von HBM ausverkauft. Wenig verwunderlich mit Blick auf die steigende Nutzung von KI und High-Performance-Computing.

HBM steht für High Bandwith Memory und basiert auf DRAM-Technologie (Dynamic Random Access Memory). Im Vergleich zu Single-Plane-DRAM erreicht HBM höhere Geschwindigkeiten bei der Datenverarbeitung. Der Grund dahinter: HBM verbindet mehrere DRAM vertikal mittels Through-Silicon-Via und Bumps.

Die höheren Geschwindigkeiten sind vorwiegend in Hochleistungsanwendungen gefragt, etwa in Künstlicher Intelligenz und maschinellem Lernen, bei High-Performance-Computing sowie in Netzwerk- und Serveranwendungen. Dazu wird HBM-DRAM oft in High-End-Grafikkarten für Gaming, Videobearbeitung und anderen grafikintensiven Anwendungen verwendet. In einer Welt, in der hohe Geschwindigkeiten immer gefragter werden, egal, ob im Rennspiel auf dem Fernseher oder bei der nächsten Antwortgenerierung eines Chatbots, sind die HBM der neuesten Generationen heiß begehrt.

Wie begehrt, das zeigt ein Interview mit Vice President Kitae Kim, Head of HBM Sales & Marketing des südkoreanischen Speicher-Hersteller SK hynix. Das Unternehmen ist einer der weltweit führenden Hersteller von Speicherchips wie DRAM und NAND-Flash-Speichern. Bereits im vergangenen Jahr war HBM von SK hynix gefragt wie nie. Und diese Nachfrage scheint nicht abzureißen.

HBM heiß begehrt

„Da das KI-Ökosystem mit der Diversifizierung und Raffinesse der generativen KI-Dienste wächst, steigt die Nachfrage nach HBM – einer leistungsstarken und hoch kapazitiven Speicherlösung“, so Kitae Kim in einem Interview auf der Webseite von SK hynix. Trotz einiger anhaltender externer Unsicherheiten glaubt man bei SK hynix daran, dass sich der Halbleiterspeichermarkt in diesem Jahr im Aufwärtstrend befindet. Weiterhin kurbelt die Anwendung von KI in immer mehr Bereichen, einschließlich On-Device2-Produkten wie mit KI ausgestatteten PCs und Smartphones, die Nachfrage nicht nur nach HBM3E, sondern auch nach anderen Produkten wie DDR5 und LPDDR5T an.

„Unsere für dieses Jahr geplante Produktionsmenge an HBM ist bereits ausverkauft. Obwohl das Jahr 2024 gerade erst begonnen hat, haben wir bereits mit den Vorbereitungen für 2025 begonnen, um dem Markt einen Schritt voraus zu sein“, so Kim.

In dem Unternehmen geht es, so lässt sich aus dem gesamten Interview ziehen, primär darum, mithilfe von Geschwindigkeit allen Mitbewerbern im Markt im Voraus zu sein. Es steht zu vermuten, dass SK hynix in diesem Jahr noch einige Hebel in Bewegung setzen wird, um zusätzliche Kapazitäten für die Produktion von HBM3 und HBM3E zu schaffen – kurzfristig kann sich das allerdings als große Herausforderung herausstellen. Es macht dennoch nicht den Anschein, als könne die Konkurrenz SK hynix kurzfristig gesehen den Rang ablaufen. Aber vielleicht langfristig?

Wenig Konkurrenz, aber viele Innovationsmöglichkeiten

Laut einer aktuellen Analyse von TrendForce teilen drei HBM-Hersteller den Markt im Wesentlichen unter sich auf:

- SK hynix (geschätzter Marktanteil 2022: 50 Prozent),

- Samsung (geschätzter Marktanteil 2022: 40 Prozent) und

- Micron (geschätzter Marktanteil 2022: 10 Prozent).

Um den Abstand zum Marktführer SK hynix zu verringern, wird von Samsung erwartet, dass sich die HBM-Produktion im Jahr 2024 im Vergleich zum Vorjahr um das Zweieinhalbfache erhöhen und im Jahr 2025 dann abermals verdoppelt wird. Dazu arbeitet man bei Samsung unter anderem an einer HBM3E-Variante, bei der zwölf DRAM gestapelt werden. HBM3E 12H bietet eine Bandbreite von bis zu 1.280 Gigabyte pro Sekunde (GB/s) und eine Speicherkapazität von 36 Gigabyte (GB). Im Vergleich zum 8-Stack HBM3 8H haben sich beide Aspekte laut Herstellerangaben um mehr als 50 Prozent verbessert. Die Massenproduktion soll in der ersten Jahreshälfte 2024 starten.

Micron hingegen scheint bei diesem Wettbewerb ins Hintertreffen geraten zu sein – doch lässt sich das so pauschal sagen? Nein. Man hatte in dem US-amerikanischen Unternehmen beschlossen, die Generation HBM3 zu überspringen und direkt an einem HBM3E mit 24 GB Speicherkapazität zu arbeiten. Dieser befindet sich seit Kurzem in der Massenproduktion und wird für Nvidias H200-GPU genutzt. Die detailliertere Vorstellung des HBM3E 12H von Micron wird für den 8. März 2024 im Rahmen von Nvidias KI-Konferenz GTC erwartet. Auf der Veranstaltung wird sicherlich auch über die Fortschritte für die nächste HBM-Generation (HBM4) gesprochen.

Flaschenhals Produktionskapazitäten?

Eingangs erwähnte Kitae Kim von SK hynix, dass die für dieses Jahr geplante Produktionsmenge an HBM bereits ausverkauft sei. Was wäre, wenn kein Hersteller die Kapazitäten erhöhen kann? Engpässe bei der Verfügbarkeit von HBM treten vor allem während der Markteinführung neuer Grafikkartenmodelle auf, insbesondere bei High-End-Grafikkarten für den Gaming- und Workstation-Bereich.

Entsprechend kann die begrenzte Produktionskapazität von HBM-Speichern etwa zu Knappheit und Preiserhöhungen aufgrund der erhöhten Nachfrage und begrenzten Verfügbarkeit führen. Engpässe sind ebenfalls in der Lage, die Entwicklung und Einführung neuer Technologien zu behindern. (sb)

:quality(80)/p7i.vogel.de/wcms/2f/ea/2feab6b1feb571107b1876b5d3980998/0111695474.jpeg)

Technologiekonflikt verschärft sich

Peking schließt US-Speicherhersteller Micron vom Markt aus

:quality(80)/p7i.vogel.de/wcms/eb/41/eb41e0036e84f1a40c960db94461d8a2/0114947165.jpeg)

Verhandlungen abgebrochen

Western Digital und Kioxia stoppen Gespräche über Fusion

(ID:49934533)

:quality(80)/p7i.vogel.de/wcms/02/46/0246a163cd4f770fc4ec4707eed026a3/0118485226.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/33/1d33974fef7933ea30c16340eebef3c9/0118272751.jpeg)

:quality(80)/p7i.vogel.de/wcms/de/e9/dee92adb2d0ccca12fc131b4b55a4c51/0118262284.jpeg)

:quality(80)/p7i.vogel.de/wcms/56/3d/563df7482bac59034c2c1ba6949eabeb/0118519606.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/e7/04e7948f02e1d792f245d19fbb6f84be/0118504854.jpeg)

:quality(80)/p7i.vogel.de/wcms/03/c5/03c5925ec95a2630b71e941343a128c5/0118433867.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/76/0d76806079a5a3d36aacdb006a7aba5a/0118407519.jpeg)

:quality(80)/p7i.vogel.de/wcms/7e/bb/7ebbb9e0afa7f66bd9abed55322eb88e/0118350007.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/89/0f89b224c4b3bb6fda7cbec9c56d9072/0118533982.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/0d/1a0d73826922a88118e8f6e04799665d/0118425986.jpeg)

:quality(80)/p7i.vogel.de/wcms/72/5f/725fbe6121731518e12f6d0b8d7397cd/0118433936.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/a5/43a5630d2a63fbe82f29e17b71d5dcb3/0118499684.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/47/7447ac45f80368ce7f86b76af1c6da99/0118407224.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/39/ce39569b6845cb072030fdf6505fb7c5/0118404058.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/22/c9228b8ec955c03dc075e8875f4cabf8/0117754897.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/6f/076f09c7a697f193091a6e6be846aef1/0117862638.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/51/305138abdaeda721646661bf6ac4fdbd/0117756540.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/b9/3cb980e98baaaadddf69a5dad4ad20a0/0117334644.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/8c/318c8c9e8d61814564d11967ccc14c04/0118494408.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/6c/eb6c99643aca684c44f5ad0411d71f3f/0118318941.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/4b/794b7d23361d39306753a0abab662274/0117836261.jpeg)

:quality(80)/p7i.vogel.de/wcms/84/64/846421e1abb64717319a401a350ed9ff/0118471925.jpeg)

:quality(80)/p7i.vogel.de/wcms/b6/06/b606e1899c3d19b8ac0bf5cdada67cd8/0118340949.jpeg)

:quality(80)/p7i.vogel.de/wcms/42/a0/42a0d035baeb02bf4467dd19ad99f583/0118352721.jpeg)

:quality(80)/p7i.vogel.de/wcms/36/94/36944586a51513ee0dc4cbb1fa410689/0118252602.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/bc/9cbcc8436fa8e226234cebdd1a101d61/0118377191.jpeg)

:quality(80)/p7i.vogel.de/wcms/70/91/7091aed6e9292abc5451815f9499984b/0118509991.jpeg)

:quality(80)/p7i.vogel.de/wcms/08/de/08de3cefb97266232f475bb011d9b0c6/0118162151.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/59/e15978926ae2637c5cc1cb07fc9428a6/0118508628.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/66/c266c5cfbc51fb7d06557ee079d406bf/0116839110.jpeg)

:quality(80)/p7i.vogel.de/wcms/3a/1a/3a1a267224e51b795ccc6b8df959f18e/0115998041.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/14/3d1447535880e284712d1daba8d7d466/0115848899.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5e/e8/5ee8685f55961/duagon-logo-without-r.png)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/105000/105004/65.png)

:fill(fff,0)/p7i.vogel.de/companies/60/37/6037a859ec501/dmb-rgb-quadrat-online.jpg)

:quality(80)/p7i.vogel.de/wcms/56/3d/563df7482bac59034c2c1ba6949eabeb/0118519606.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/14/891466dc6e506808ac85d6d2092a0515/0118057843.jpeg)