KI-Chip Nvidia Blackwell: KI-Revolution der nächsten Generation

Anbieter zum Thema

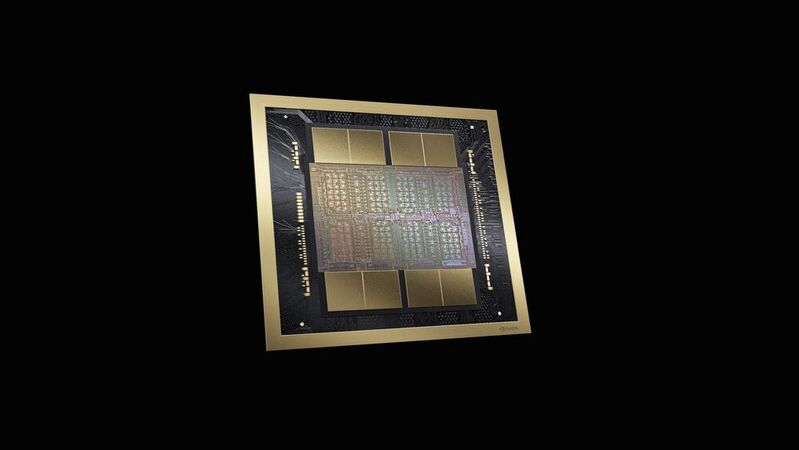

Der Chipkonzern Nvidia will seine führende Rolle bei Technik für künstliche Intelligenz ausbauen. Firmenchef Jensen Huang stellte die aktuelle KI-Plattform vor: den Chip Blackwell. Dieser ist noch einmal leistungsfähiger als der aktuelle Grace Hopper.

Nvidia profitiert vom aktuellen Boom bei künstlicher Intelligenz. Damit das Unternehmen weiter eine führende Rolle in der KI-Technik einnehmen wird, hat Nvidia-Chef Jensen Huang in seiner Keynote am vergangenen Montag eine neue Generation einer KI-Computerplattform vorgestellt. Das System Blackwell bezeichnet Nvidia als „Antrieb einer neuen industriellen Revolution“. Der KI-Chip ist nach dem amerikanischen Mathematiker David Blackwell benannt.

Der Konzern will auch seine Rolle bei der Erzeugung von Inhalten mit künstlicher Intelligenz ausbauen. „Das Blackwell-System sei darin 30-mal besser als Hopper“, betonte Huang am Montag auf der hauseigenen Entwicklerkonferenz GTC in San Jose.

Der GB200 Grace Blackwell Chip verbindet zwei Tensor-Core-GPUs vom Typ B200 mit der Grace-CPU über einen Die-to-Die-Link. Konkret handelt es sich um den Ultra-Low-Power NVLink mit einer Datenrate von 900 GByte/s. Die von Nvidia entwickelte Blackwell-GPU soll in der Lage sein, Modelle mit bis zu 10 Billionen Parametern zu berechnen. Dazu stehen auf dem Chip 208 Milliarden Transistoren bereit.

Für eine entsprechend hohe KI-Rechenleistung können Systeme, die mit dem GB200 betrieben werden, an die Ethernet-Plattformen Quantum-X800 InfiniBand und Spectrum-X800 angeschlossen werden. Damit können Geschwindigkeiten von bis zu 800 GBit/s erreicht werden.

Einsatz des Blackwell Chips

Eingesetzt wird der GB200 als Schlüsselkomponente im GB200 NVL72. Dabei handelt es sich um eine leistungsstarke und wassergekühlte Rack-Lösung, die 36 GB200-Beschleuniger enthält. Jeder GB200-Beschleuniger besteht aus einer Grace-CPU und zwei Blackwell-GPUs, im Gegensatz zum vorherigen GH200-Beschleuniger, der eine Grace-CPU und eine Hopper-GPU enthielt.

Die GPUs sind nicht mehr auf dem gleichen Board wie die Grace-CPU angeordnet, sondern auf einem separaten Modul innerhalb des Servers. Die Verbindung zwischen der Grace-CPU und den Blackwell-GPUs erfolgt über NVLink C2C mit einer bidirektionalen Bandbreite von 900 GB/s. Jeder GB200-Beschleuniger verfügt über insgesamt 864 GByte Speicherkapazität, wobei jede der beiden Blackwell-GPUs mit 192 GByte HBM3E-Speicher an die Grace-CPU angebunden ist.

Daten mit der BlueField-3 verarbeiten

Der GB200 NVL72 enthält die Datenverarbeitungseinheiten BlueField-3, die es ermöglichen, Cloud-Netzwerkbeschleunigung, Composable Storage, Zero-Trust-Sicherheit und GPU-Compute-Elastizität in Hyperscale-KI-Clouds zu realisieren.

Diese Kombination bietet eine bis zu 30-fache Leistungssteigerung im Vergleich zur gleichen Anzahl von H100 Tensor Core GPUs für LLM-Inferenz-Workloads von Nvidia. Zusätzlich reduziert der GB200 NVL72 die Kosten und den Energieverbrauch um das bis zu 25-fache. Diese Integration von BlueField-3 in den GB200 NVL72 ermöglicht fortschrittliche Funktionen und eine erhebliche Verbesserung der Leistung und Effizienz in rechenintensiven KI-Anwendungen und Cloud-Umgebungen.

Was mit dem KI-Chip möglich ist

Die Hardware von Nvidia dominiert die Rechenzentren für das KI-Training. Darüber hinaus plant Nvidia, seine Rolle bei der Erstellung von Inhalten mit künstlicher Intelligenz auszubauen. CEO Jensen Huang betonte, dass das Blackwell-System beim KI-Training 30-mal besser sei als Hopper. Neben dieser Leistungsoptimierung bietet Nvidia neue Software an, die über Schnittstellen auch über die Cloud genutzt werden kann.

„Mit Grace Hopper hätte man zum Beispiel den Chatbot ChatGPT innerhalb von drei Monaten mit 8.000 Nvidia-Chips und einem Stromverbrauch von 15 Megawatt trainieren können“, sagte Huang. „Mit Blackwell schaffe man das in derselben Zeit mit 2.000 Chips und 4 Megawatt Strom.

Die Zukunft der künstlichen Intelligenz

Nvidia hat ein Computersystem für die Zukunft entwickelt, das darauf abzielt, dass die meisten Inhalte nicht mehr vorgefertigt aus Speichern abgerufen werden, sondern dass KI-Software sie basierend auf der aktuellen Situation frisch erzeugt.

Jensen Huang, CEO von Nvidia, ist überzeugt, dass diese Entwicklung bevorsteht. Ein Beispiel dafür ist die Möglichkeit, sich in Zukunft mit Gebäuden per Chatbot zu unterhalten, anstatt Daten an verschiedenen Orten einzusehen. Diese Vision zeigt den Fortschritt in der KI-Technologie und wie sie in der Lage sein wird, personalisierte und kontextbezogene Inhalte in Echtzeit zu generieren und somit die Interaktionen mit Technologie auf eine neue Ebene zu heben.

Die ursprünglich für Grafikkarten entwickelten Nvidia-Techniken bewähren sich schon seit Langem bei der Rechenarbeit für Anwendungen mit künstlicher Intelligenz. Konkurrenten wie Intel und AMD konnten bisher keinen Anschluss finden. Das lässt das Geschäft – und den Börsenwert – von Nvidia rasant wachsen. Große KI-Unternehmen wie Microsoft, Google und Amazon planen bereits den Einsatz von Blackwell.

(ID:49970123)

:quality(80)/p7i.vogel.de/wcms/08/cb/08cb1b39d0e5c58591bc70e8b63a0220/0118078425.jpeg)

:quality(80)/p7i.vogel.de/wcms/8f/e8/8fe846e9bc5577c77430aee8a0a68599/0118091177.jpeg)

:quality(80)/p7i.vogel.de/wcms/de/89/de8956f8a3c454ac651a8ffa3303c89f/0117868030.jpeg)

:quality(80)/p7i.vogel.de/wcms/d6/10/d6101a2aac8c7d2cab2ff31546979254/0118103063.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/c2/29c2b968dc07be08e6062d8e6d8c387b/0118061450.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/0f/0d0f07610ae64127bd49e5512e847f00/0118071390.jpeg)

:quality(80)/p7i.vogel.de/wcms/77/25/7725cc7179a8901c88f54d63f786f503/0118089114.jpeg)

:quality(80)/p7i.vogel.de/wcms/b8/cb/b8cb90f76a1c9b4641c258c77baa6452/0117870997.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/54/eb54f8523a66b2a8b1a81599213a2849/0118037299.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/c6/5fc62a91bffb6c673c36722011f8205c/0118076327.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/51/1e513481ef401300756c3bb189188c01/0117631502.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/c3/4ac36d52b7b85caa24dfb33c6d24dcb3/0116839547.jpeg)

:quality(80)/p7i.vogel.de/wcms/03/f9/03f94da2d43a26f1c5e29951e119dc15/0118070581.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/22/c9228b8ec955c03dc075e8875f4cabf8/0117754897.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/6f/076f09c7a697f193091a6e6be846aef1/0117862638.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/51/305138abdaeda721646661bf6ac4fdbd/0117756540.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/b9/3cb980e98baaaadddf69a5dad4ad20a0/0117334644.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/4b/794b7d23361d39306753a0abab662274/0117836261.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/88/f388bad02124a8ac7fc5663627838b69/0117819459.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/cc/2bccc41bb07c895dda4839b927d8c265/0116514416.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/5a/1e5a931b4b81371d6761358130476db5/0117914243.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/a8/f7a8de2339926d03f6309495bb3e3cdf/0117808261.jpeg)

:quality(80)/p7i.vogel.de/wcms/18/32/1832350986a019c0f74079c2fd03fa28/0117909885.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/39/ce39b8746f3a7c4fe740dd2ab7ae398e/0117870832.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/5b/435ba2f9a9f3626b158e8c9e21b3ef86/0118068989.jpeg)

:quality(80)/p7i.vogel.de/wcms/16/cc/16cc54cea371a36ebef7a53b952f8516/0118069700.jpeg)

:quality(80)/p7i.vogel.de/wcms/8b/21/8b21dc0d8a22fffb04f5a76e1ae7573b/0117948570.jpeg)

:quality(80)/p7i.vogel.de/wcms/2a/7e/2a7efec3a497d5dc95ab215c5d23157d/0118039147.jpeg)

:quality(80)/p7i.vogel.de/wcms/89/14/891466dc6e506808ac85d6d2092a0515/0118057843.jpeg)

:quality(80)/p7i.vogel.de/wcms/13/f4/13f45928ee8acff5534a6c615b4ceef6/0117954493.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/66/c266c5cfbc51fb7d06557ee079d406bf/0116839110.jpeg)

:quality(80)/p7i.vogel.de/wcms/3a/1a/3a1a267224e51b795ccc6b8df959f18e/0115998041.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/14/3d1447535880e284712d1daba8d7d466/0115848899.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/65/f1/65f186172d9f0/syslogic-logotype-alt-navy-mint.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/72000/72046/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/61/56/6156a4b225f39/simscale-logo-flatbg-color.jpeg)

:quality(80)/p7i.vogel.de/wcms/e2/3e/e23e1bc9e822988be9ab534ceaa8c7a1/0115586679.jpeg)

:quality(80)/p7i.vogel.de/wcms/52/e9/52e98bce3b5076631a02132857e5d5a0/0114775669.jpeg)