EP Basics: Bildverarbeitung Bildverarbeitung: So funktionieren bildbasierte Sensoren

Anbieter zum Thema

Wärmebildsensoren, Kameramodule und Lidar-Systeme sind bildbasierte Sensoren. Sie nehmen ihre Umgebung zwei- oder dreidimensional wahr. Wie sie aufgebaut sind und wie sie funktionieren.

Im Gegensatz zu klassischen Sensoren erfassen bildbasierte Sensoren Messgrößen nicht punktuell an einer einzelnen Messstelle. Sie nehmen vielmehr ein zwei- oder dreidimensionales Abbild der Umgebung auf. Die Rede ist von Wärmebildsensoren, von Kameramodulen und von sogenannten Lidar-Systemen zur laserbasierten dreidimensionalen Abtastung der Umgebung.

Diese Sensoren werden mit einer leistungsfähigen, bildverarbeitenden Algorithmik kombiniert, die eine Vielzahl interessanter Anwendungen wie Objekt- und Personenerkennung oder autonomes Fahren ermöglicht.

Wärmebilder im industriellen Umfeld

Seit längerem werden zum Beispiel zur Aufnahme von Wärmebildern im industriellen Umfeld oder an Hausfassaden mehr oder weniger großvolumige Wärmbildkameras eingesetzt. In den letzten wenigen Jahren wurden nun kleinvolumige Sensoren eingeführt, die Wärmebilder mit Auflösungen von beispielsweise 640 x 512 Pixel (um auf einen weit verbreiteten Typ zu referenzieren) und Messzeiten von deutlich unter einer Sekunde pro Bild erzeugen. Diese können über konventionelle Videoausgänge oder über eine Digitalschnittstelle ausgelesen werden.

Es werden sowohl reine Sensorchips als auch komplette Miniatursensormodule mit integrierter Optik in verschiedensten Brennweiten angeboten.

Die Sensoren werten Infrarotstrahlung aus

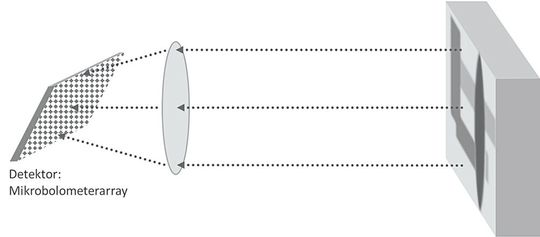

Derartige Sensoren basieren ähnlich den Pyrometern auf der Auswertung der Infrarotstrahlung. Bild 1 zeigt das Prinzip: Eine Oberfläche wird mit einer Optik auf einen 2D-Detektorchip abgebildet. Die bildaufnehmende Struktur ist ein in Pixel unterteiltes Flächenelement. Jedes Pixel wertet die durch die einfallende Strahlung generierte Erwärmung aus, das sogenannte Bolometerprinzip.

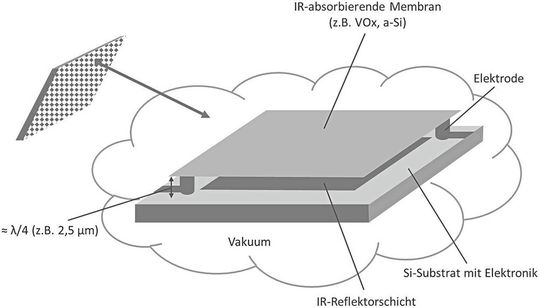

Die Struktur eines einzelnen Pixels zeigt Bild 2. Eine die eigentliche Infrarotstrahlung aufnehmende Membran aus typischerweise Vanadiumoxid (VOx) oder amorphem Silizium (a-Si) ist wärmeisoliert über einer darunterliegenden Ausleseelektronik aufgehängt. Die Aufhängung erfolgt über zwei Stäbe, die gleichzeitig als Elektroden dienen. Über diese Elektroden wird der elektrische Widerstand der Membran gemessen, der sich bei Erwärmung ändert.

Die Membran nimmt zunächst nur einen Teil der einfallenden Strahlung auf. Der verbleibende Teil durchläuft die Membran, wird jedoch durch die darunter befindliche Reflektorschicht wieder zurückgeworfen. Da der Abstand zwischen Reflektorschicht und Membran auf etwa ¼ der mittleren Wellenlänge der typischen Infrarotstrahlung dimensioniert ist, ergibt sich eine Resonatorstruktur für eine maximale Absorption. Zur thermischen Isolation wird die Umgebung vakuumisoliert. Dazu muss der Chip in ein geeignetes Gehäuse verbaut sein.

Messabweichung durch Eigenrauschen

Entsprechende Chips und damit aufgebaute Sensormodule sind für verschiedene Wellenlängenbereiche innerhalb des Spektrums von ungefähr 0,8 bis 14 μm und optimiert auf verschiedene Oberflächen erhältlich. Zum Vergleich: Sichtbares Licht umfasst Wellenlängen von ungefähr 0,4 bis 0,7 μm. Heute verfügbare Wärmebildsensoren bieten Auflösungen von 320 x 240 bis 1.024 x 768.

Ein wichtiges Qualitätsmerkmal ist die sogenannte NETD (Noise Equivalent Temperature Difference), welche meist innerhalb von 0,06 bis 1 K (bei 25 °C Umgebungstemperatur) liegt. Hierunter versteht man die maximale Messabweichung, die durch das Eigenrauschen des Chips entsteht. Die Bildfrequenzen liegen bei ungefähr 1 bis 50 Hz.

Kameras und Smartphones für sichtbares Licht

Herkömmliche Bilder im sichtbaren Spektralbereich können, außer mit herkömmlichen Kameras und Smartphones, mit kompakten Kameramodulen erfasst werden und über ähnliche Anschlüsse wie bei Wärmebildsensoren nachgeschalteten Auswerterechnern zugeführt werden. Als Detektor werden fast ausschließlich die aus der Welt der Digitalkameras bekannten CMOS-Bildsensoren (Complementary Metal Oxide Semiconductor) eingesetzt.

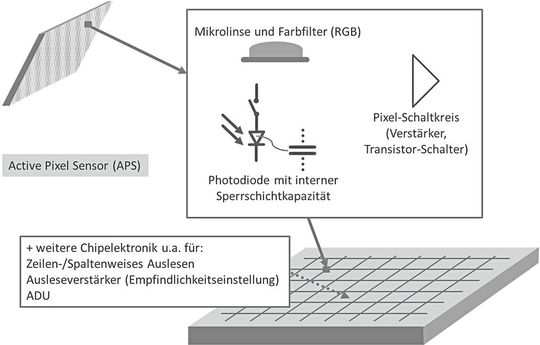

Bild 3 zeigt den Aufbau eines typischen CMOS-Bildsensorchips. Jedes Pixel besitzt eine Photodiode. Diese werden üblicherweise in Sperrpolung betrieben und weisen dabei eine interne Sperrschichtkapazität auf. Vor einer Belichtung werden alle Photodioden eines Sensorchips an eine Referenzspannung gelegt, welche in den jeweiligen Sperrschichtkapazitäten gespeichert wird.

In Abhängigkeit von Lichtstärke am jeweiligen Pixel und Belichtungszeit werden die Kapazitäten dann durch einen mehr oder weniger großen, durch die Belichtung generierten Photostrom entladen. Nach der Belichtung werden alle Kapazitäten durch sequentielles Ansteuern innerhalb einer Matrixstruktur mit Zeilen und Spalten nacheinander ausgelesen und über einen Analog-Digital-Umsetzer (ADU) auf ihre Spannung digitalisiert.

In einer nachgeordneten Elektronik werden die einzelnen Pixelspannungen als Gesamtbild in einem Bildspeicher abgelegt. Eine über die Chipoberfläche gelegte Schicht aus Mikrolinsen sorgt dafür, dass weitgehend das gesamte auf eine Pixelfläche einfallende Licht auf den aktiven Part der Photodiode gebündelt wird.

Von Helligkeitswerten und den Farbinformationen

Photodioden detektieren zunächst nur Helligkeitswerte und keine Farben. Für Farbinformationen werden die Sensorchips in der am weitesten verbreiteten Bauform mit einer Filterschicht überzogen. Die Filterschicht ist waben- oder schachbrettförmig jeder Photodiode als Farbfilter für eine der drei RGB-Grundfarben Rot, Grün oder Blau vorschaltet (Mosaikfilter).

Pro Pixel wird nur ein Grundfarbwert detektiert. Mit einem speziellen Algorithmus wird in der nachgeschalteten Elektronik über einen sehr schnellen Signalprozessor dann per Interpolation aus den Farbwerten benachbarter Pixel jedem einzelnen Pixel eine komplette Farbinformation wieder zugeordnet.

Sensoren mit höherer Lichtempfindlichkeit

Das menschliche Auge ist für die einzelnen Grundfarben unterschiedlich empfindlich, weshalb sich die Anzahl der in einem Chip verbauten roten, grünen und blauen Pixel unterscheidet. Beim Bayer-Filter wechseln sich Zeilen ab, in denen sich wiederum Grün mit Rot oder Grün mit Blau spaltenweise abwechseln. Wodurch 50 Prozent aller Pixel auf Grün reagieren und jeweils 25 Prozent auf Rot und Blau.

Bei den bisher dominierten Sensorchips verliefen aus produktionstechnischen Gründen die zur Realisierung der Matrixstruktur notwendigen Leiterbahnen zwischen Chipoberfläche und der Ebene mit den Photodioden (frontseitige Beleuchtung). Die Leiterbahnstrukturen reflektieren oder absorbieren einen Teil des einfallenden Lichts.

Für eine höhere Lichtempfindlichkeit sind einige Hersteller speziell bei Chips mit hoher Pixelzahl und damit kleinerer lichtempfindlicher Fläche pro Pixel zu den in der Produktion aufwendigeren Aufbauvarianten mit rückseitiger Beleuchtung übergegangen, bei denen die Photodioden direkt unterhalb der Linsen-/Filterebene liegen.

Ein Dreischichtsensor als spezielle Ausführung

Bei dem Dreischichtsensor erfolgt für jedes Pixel eine komplette Farbauswertung. Der Effekt dahinter: Licht unterschiedlicher Wellenlänge dringt unterschiedlich tief in Silizium ein. Man bringt bei diesen Sensorchips pro Pixel jeweils drei Photodioden in einem bestimmten Abstand übereinander an. Die der Chipoberfläche nächste Diode detektiert weitgehend die Blauanteile, die Diode darunter die Grünanteile und die unterste Diode die Rotanteile.

Die sich ergebenden Empfindlichkeitsunterschiede der drei Diodenebenen werden von einem Algorithmus korrigiert. Die höhere farbliche Auflösung wird durch der Korrektur der nicht so hohen Farbtreue wie bei der filterbasierten Farbdetektion erkauft. Die Auflösungen der industriell meist eingesetzten Bildsensormodule bewegt sich von ungefähr 720 x 576 bis 7.380 x 4.932. Dazu die Auflösung pro Pixelfarbkanal von ungefähr acht bis zwölf Bit. Üblicherweise angebotene Bildfrequenzen liegen bei 5 bis 50.000 Hz.

Das Lidar-System tastet den Raum ab

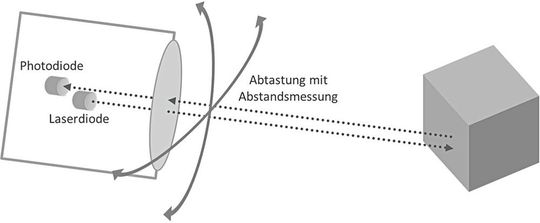

In jüngster Zeit kommen verstärkt sensortypisch miniaturisierte Ausführungen von Messeinrichtungen auf den Markt, die ihre Umgebung mit einem Laserstrahl sehr schnell abtasten. Dadurch entsteht ein dreidimensionales Abbild. Das zugrundeliegende Lidar-Verfahren ist in Bild 4 skizziert.

Ein Laser tastet in schneller Sequenz den Raum ab, indem die Lasereinheit selbst oder ein davor angebrachter Spiegel in zwei Raumrichtungen systematisch abgelenkt wird. Alternativ sind rotierende Anordnungen möglich. Mit einer gewissen Auflösung wird dann pro neuer Laserstrahlposition dessen Laufzeit gemessen, wodurch der Abstand vom Lidar-Sensor zum abgetasteten Oberflächenpunkt bestimmt werden kann. Jedem Raumpixel wird ein Abstandswert zugeordnet. Das Ergebnis ist ein dreidimensionales Bild aus der Perspektive des Sensors. Gegenüber dem herkömmlichen dreidimensionalen Bild ist es entsprechend verzerrt. Algorithmen können das korrigieren.

Lidar-Modul für fahrerlose Fahrzeuge

Ein Lidar-Modul speziell für fahrerlose Fahrzeuge mit wesentlichen Kenndaten: Durchmesser: 120 mm, Höhe: 110 mm, Erfassungsbereich: 150 m, Messabweichung Abstand: < 3 cm, horizontaler Scanbereich: 360°, horizontale Scanrate: 5 bis 20 Hz, vertikaler Scanbereich: ±15°, Winkelauflösung horizontal: 0,09° bis 0,36° (je nach Scanrate), Winkelauflösung vertikal: 2° und Wellenlänge Laser: 905 nm.

Im Unterschied zum Grundprinzip (Bild 4) erfolgt keine echte Ablenkung eines Laserstrahls in vertikaler Richtung. Es existieren 16 parallele Laserstrahlengänge, die versetzt um 2° jeweils für einen vertikalen Sektor zuständig sind. Vertikal werden 16 Raumpixel abgetastet, was für fahrerlose Fahrzeuge ausreichend ist.

Literaturempfehlung

Jörg Böttcher: Kompendium Messtechnik und Sensorik (2. Auflage). ISBN 9783751932967 (Paperback) oder ISBN 9783752632491 (E-Book), Verlag: Books on Demand. Der Autor ist Herausgeber des Open-Access-Online-Kompendiums mit Multiple-Choice-Zertifikatstest.

* Prof. Dr.-Ing. Jörg Böttcher hat eine Professur für Regelungstechnik und Elektrische Messtechnik an der Universität der Bundeswehr in München inne.

(ID:47688312)

:quality(80)/p7i.vogel.de/wcms/02/46/0246a163cd4f770fc4ec4707eed026a3/0118485226.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/33/1d33974fef7933ea30c16340eebef3c9/0118272751.jpeg)

:quality(80)/p7i.vogel.de/wcms/de/e9/dee92adb2d0ccca12fc131b4b55a4c51/0118262284.jpeg)

:quality(80)/p7i.vogel.de/wcms/56/3d/563df7482bac59034c2c1ba6949eabeb/0118519606.jpeg)

:quality(80)/p7i.vogel.de/wcms/04/e7/04e7948f02e1d792f245d19fbb6f84be/0118504854.jpeg)

:quality(80)/p7i.vogel.de/wcms/03/c5/03c5925ec95a2630b71e941343a128c5/0118433867.jpeg)

:quality(80)/p7i.vogel.de/wcms/0d/76/0d76806079a5a3d36aacdb006a7aba5a/0118407519.jpeg)

:quality(80)/p7i.vogel.de/wcms/7e/bb/7ebbb9e0afa7f66bd9abed55322eb88e/0118350007.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/89/0f89b224c4b3bb6fda7cbec9c56d9072/0118533982.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/0d/1a0d73826922a88118e8f6e04799665d/0118425986.jpeg)

:quality(80)/p7i.vogel.de/wcms/72/5f/725fbe6121731518e12f6d0b8d7397cd/0118433936.jpeg)

:quality(80)/p7i.vogel.de/wcms/43/a5/43a5630d2a63fbe82f29e17b71d5dcb3/0118499684.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/47/7447ac45f80368ce7f86b76af1c6da99/0118407224.jpeg)

:quality(80)/p7i.vogel.de/wcms/ce/39/ce39569b6845cb072030fdf6505fb7c5/0118404058.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/22/c9228b8ec955c03dc075e8875f4cabf8/0117754897.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/6f/076f09c7a697f193091a6e6be846aef1/0117862638.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/51/305138abdaeda721646661bf6ac4fdbd/0117756540.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/b9/3cb980e98baaaadddf69a5dad4ad20a0/0117334644.jpeg)

:quality(80)/p7i.vogel.de/wcms/31/8c/318c8c9e8d61814564d11967ccc14c04/0118494408.jpeg)

:quality(80)/p7i.vogel.de/wcms/eb/6c/eb6c99643aca684c44f5ad0411d71f3f/0118318941.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/4b/794b7d23361d39306753a0abab662274/0117836261.jpeg)

:quality(80)/p7i.vogel.de/wcms/84/64/846421e1abb64717319a401a350ed9ff/0118471925.jpeg)

:quality(80)/p7i.vogel.de/wcms/b6/06/b606e1899c3d19b8ac0bf5cdada67cd8/0118340949.jpeg)

:quality(80)/p7i.vogel.de/wcms/42/a0/42a0d035baeb02bf4467dd19ad99f583/0118352721.jpeg)

:quality(80)/p7i.vogel.de/wcms/36/94/36944586a51513ee0dc4cbb1fa410689/0118252602.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/bc/9cbcc8436fa8e226234cebdd1a101d61/0118377191.jpeg)

:quality(80)/p7i.vogel.de/wcms/70/91/7091aed6e9292abc5451815f9499984b/0118509991.jpeg)

:quality(80)/p7i.vogel.de/wcms/08/de/08de3cefb97266232f475bb011d9b0c6/0118162151.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/59/e15978926ae2637c5cc1cb07fc9428a6/0118508628.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/66/c266c5cfbc51fb7d06557ee079d406bf/0116839110.jpeg)

:quality(80)/p7i.vogel.de/wcms/3a/1a/3a1a267224e51b795ccc6b8df959f18e/0115998041.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/14/3d1447535880e284712d1daba8d7d466/0115848899.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/64/21/64219ce08bf52/logo.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/68800/68851/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/5e/4d/5e4d1371cff23/logo.jpg)

:quality(80)/p7i.vogel.de/wcms/17/68/17684d18706a25c18088a442a16b7173/0117358031.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/3b/f83b5dcb154d9554d0fa3ce4c0af4a26/0113660310.jpeg)